Le piccole dev-board a bassa potenza sullo stile di Raspberry Pi stanno cavalcando l’onda del successo e Canonical ha intenzione di dare una spinta in più.

Uno degli aspetti da migliorare nel campo dev-board è l’assistenza post-vendita all’utente finale. Sappiamo quanto sia importante la componente software in questo settore, ce lo ha dimostrato proprio Raspberry Pi.

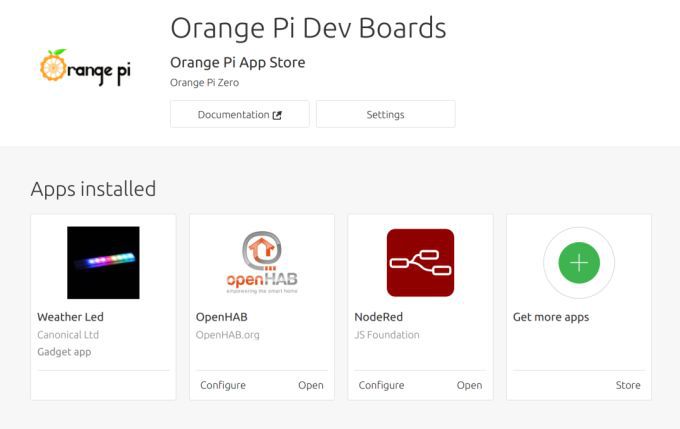

App store per le Orange Pi

In mancanza di un gruppo di coders volontari, quindi, il team di Orange Pi ha deciso di collaborare con Canonical creando un App Store per tutte le board Orange Pi basate su Ubuntu Linux.

Tecnicamente la maggior parte dei sistemi operativi GNU/Linux ha un suo “app store”, seppur sotto forma di pacchetti/repository, che permette di scaricare e installare software utilizzando comandi da riga di comando come apt-get o strumenti GUI come Synaptic. Il nuovo Orange Pi App Store sarà completamente basato sul sistema Snap.

Al di là dei metodi di scaricamento, comunque, va preso atto che Shenzhen Xunlong Software e Canonical hanno lavorato insieme per far crescere sia la community delle Orange Pi sia quella di Ubuntu, quindi per un vantaggio reciproco. Ricordiamo che le dev board della società supportano anche altri sistemi operativi, come Android, Debian e Raspbian.

Vi ricordiamo che seguirci è molto semplice: tramite la pagina Facebook ufficiale, tramite il nostro canale notizie Telegram e la nostra pagina Google Plus. Da oggi, poi, è possibile seguire il nostro canale ufficiale Telegram dedicato ad Offerte e Promo!

Qui potrete trovare le varie notizie da noi riportate sul blog. È possibile, inoltre, commentare, condividere e creare spunti di discussione inerenti l’argomento.