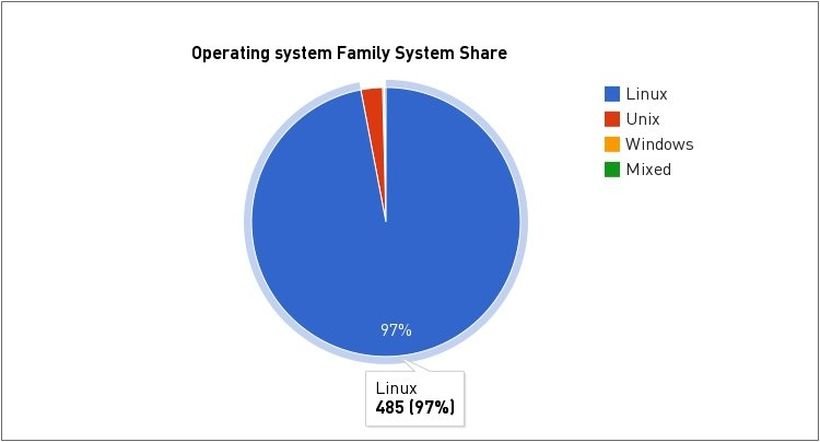

Top500 ha rilasciato alcuni dettagli riguardanti la classifica dei supercomputer, Linux è il sistema operativo più utilizzato con il 97%.

In questi anni abbiamo parlato molto spesso di Top500, la famosa classifica che riguarda i computer più potenti al mondo (denominati supercomputer). Il portale Top500 rilascia ogni sei mesi una classifica aggiornata dei 500 supercomputer più potenti al mondo che vede al primo posto Tianhe-2 o TH-2, potentissimo sistema cinese installato a Guangzhou, presso il National Supercomputer Center, e basato su Ubuntu Linux. Stando alla recente classifica di Top500, Linux è il sistema operativo utilizzato in circa il 97% dei 500 più potenti supercomputer al mondo, aumentando cosi il numero di sistemi che si basano sul sistema operativo libero.

Per quanto riguarda le nazioni, gli Stati Uniti continuano a dominare con ben 231 supercomputer, al secondo posto troviamo la Cina con 61 supercomputer e il terzo posto è andato a Giappone con 32. Poi completare i primi dieci posti triviamo Francia (30), Regno Unito ( 30), Germania (26), Corea del Sud (9) India (9), Australia (9) e la Russia (9).

Stando la classifica Top500 il principale produttore di supercomputer è HP (35,8%), seguita da IBM (30,6%), Cray Inc (12,4%) SGI (4,6%), Bull (3,6%), Dell (1,8%), Fujitsu (1.6 %), NUDT (1%), RSC Group (0,8%) e Atipa (0,6%)

Stando la classifica Top500 il principale produttore di supercomputer è HP (35,8%), seguita da IBM (30,6%), Cray Inc (12,4%) SGI (4,6%), Bull (3,6%), Dell (1,8%), Fujitsu (1.6 %), NUDT (1%), RSC Group (0,8%) e Atipa (0,6%)

Uno sguardo alle statistiche dei processori più utilizzati: al primo posto troviamo Intel Xeon E5 / SandyBridge (46,2%), Intel Xeon E5 / Ivybridge (27%), Intel Xeon E5 Haswell (5,2%), Xeon serie 5600 (5%), Power BQC (5%) e POWER 7 (2,7%)

Come possiamo notare dal grafico sopra Linux ha avuto un’incredibile crescita nei supercomputer, passando da 0 a fine anni 90 fino arrivare a ben 485 su 500 nel 2014.