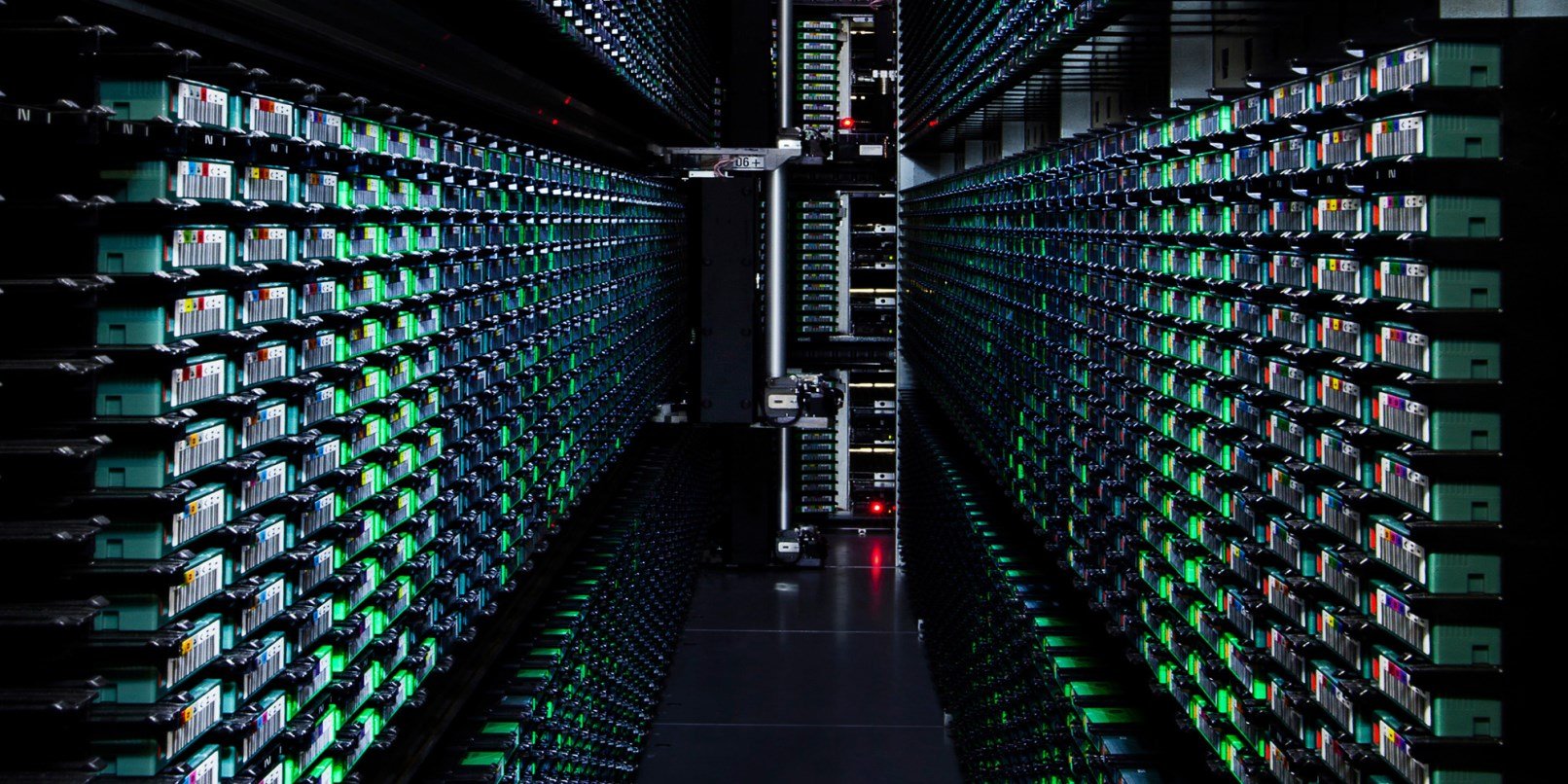

Google fornisce servizi in tutto il mondo, e ha data-center sparsi in tutto il globo; un elemento critico di queste strutture è lo storage. All’ultima conferenza FAST (File And Storage Technologies), Google ha affrontato un tema interessante: i dischi per i data-center e l’affidabilità degli SSD nell’uso reale.

In breve, Google arriva ad una conclusione: sarebbe opportuno riprogettare i dischi, sia dal punto di vista fisico (con effetti a lungo termine), sia dal punto di vista software (con potenziali effetti anche nel breve termine). Google ha tutte le capacità di realizzare in proprio le soluzioni che propone, ma vuole iniziare a discutere pubblicamente come procedere per creare dei nuovi standard, condivisi e duraturi. Vediamo cosa ha proposto.

Per Google un data center ha due priorità fondamentali:

- TCO (Total Cost of Ownership), ovvero il costo complessivo di una certa tecnologia (la somma di acquisizione, funzionamento, manutenzione e sostituzione);

- Latenza, ovvero in quanto tempo sono iniziate e completate le operazioni di lettura o scrittura.

Google afferma che per quanto concerne l’immagazzinamento a lungo termine gli SSD costano troppo. Certo, abbattono la latenza, ma in una valutazione TCO meglio la tecnologia tradizionale che offre maggiori garanzie.

Google non si limita pero’ a porre il problema ma presenta anche alcuni suggerimenti per superare gli attuali limiti:

- il cambio del diametro dei dischi;

- l’aumento del numero di dischi impilati in una singola unità;

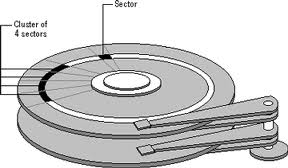

La dimensioni dei piatti (che girano fisicamente), non è una scelta frutto di una valutazione, ma semplicemente il retaggio dell’era dei floppy disk: quella era la dimensione e quella è rimasta. Dischi di dimensioni diverse avrebbero diversi vantaggi e svantaggi: dischi con diametri più piccoli ridurrebberò le latenze, dischi con diametri maggiori aumenterebbero la capacità degli stessi. Anche l’altezza delle unità è una questione storica, e dipende dalla quantità di piatti impilati (da 3 a 5) che girano assieme e che condividono l’elettronica di controllo: Google propone di aumentare semplicemente il numero di piatti impilati.

Ecco una lista delle idee:

- diminuzione della memoria cache dedicata con spostamento di tale funzione alla RAM dell’host;

- cambio della connessione da SATA/SAS a PCI-E;

- aumento del numero di testine di lettura;

- uso di mini-array: un’unità non sarebbe più composta da una pila di dischi e dalla sua elettronica, ma da una serie di pile di dischi (anche con caratteristiche diverse) e l’elettronica di controllo condivisa.

Si ipotizzano unità composte a loro volta da alcuni hard disk, magari alcuni più specializzati per la latenza e alcuni per la capacità; pur aumentando la complessità dell’unità, i vantaggi sarebbero non solo di prestazioni ma anche di costi: l’elettronica di controllo sarebbe unica dell’array, e non una per ogni hard disk.

Google propone poi una serie di miglioramenti firmware:

- Profilazione dei dati

- Tentativi di nuova lettura gestiti dall’host

- Operazioni in backround

- Dimensioni più grandi del settore

Tutti prevedono una maggiore interazione tra il firmware del disco e la macchina che fisicamente lo usa, concentrando nel disco la gestione più semplice (ottimizzata sulle sue caratteristiche) e lasciando all’host (che ha la potenza di calcolo necessaria all’integrazione nell’infrastruttura) la gestione delle priorità di lettura o scrittura.

I più curiosi possono trovare la relazione completa cliccando qui.

Google è quindi fermamente intenzionata a rivoluzionare il settore, ci riuscirà?

[Fonte]