Pokemon è ancora al centro dell’attenzione ma stavolta non a causa della popolare applicazione sviluppata da Niantic per iOS e Android.

Trend Micro, leader mondiale per la protezione dati in internet e per la sicurezza nel cloud, ha da pochi giorni rilevato un nuovo rootkit che ha come bersaglio i dispositivi Linux-based. Il rootkit è in grado di colpire sistemi a 32 bit o a 64 bit sia basati su Intel che su ARM. Persino i sistemi embedded (come i router) sono a rischio.

Il nome del rootkit è Umbreon, nel videogioco Umbreon è un Pokemon che si nasconde nell’ombra, da qui il nome del virus.

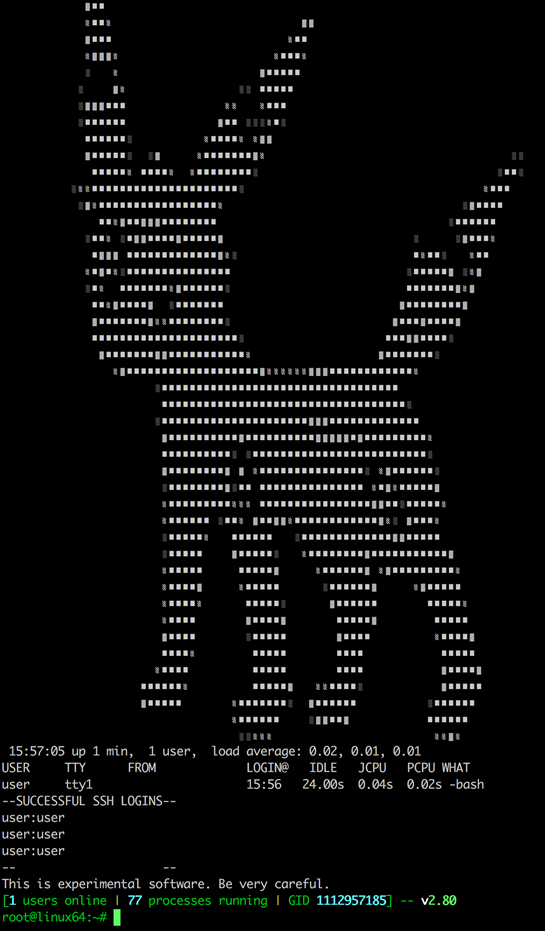

Dopo essersi infiltrato nel vostro pc Umbreon crea un account utente fittizio che gli hacker usano per accedere al device via SSH. Questa la home screen che viene mostrata quando il virus vi ha colpito:

Trend Micro l’ha contrassegnato come un rootkit ring 3 ovvero un virus che non va a toccare il kernel ma agisce a livello utente è quindi in grado di spiare tutto ciò che fate col vostro pc. E’ in grado di intercettare le più importanti system call (read, write etc) del sistema operativo che vengono gestite usando le librerie di Umbreon essendo caricate per prime dal loader.

Il virus, interamente scritto in C, va a sostituire la glibc (GNU C library): il loader carica prima lui e le sue librerie fasulle invece di quelle originali. Pertanto è rilevabile solo da software che non sono basati sulla libc.

La backdoor espeon

Espeon, altro nome di Pokemon, è invece una backdoor usata dai malintenzionati per accedere ai sistemi infettati con Umbreon.

Espeon va a creare una shell, che viene configurata per collegarsi automaticamente ai pc degli hacker agendo come una reverse shell permettendo il bypass dei firewall.

Espeon cattura tutto il traffico TCP che giunge all’interfaccia Ethernet.

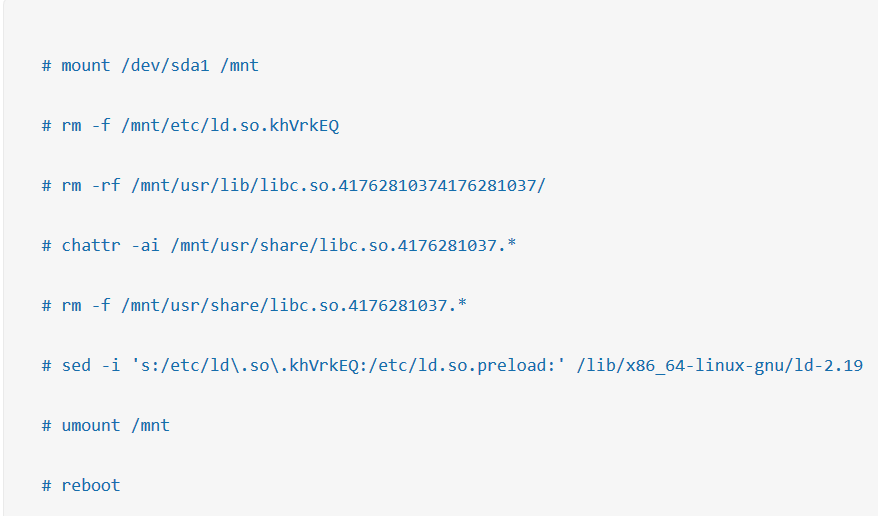

Come rimuoverlo

E’ possibile rimuoverlo dopo essere stati colpiti ma non è un’operazione semplice e potrebbe andare a compromettere il sistema, come spiegato sul blog ufficiale di Trend Micro.

Questa la mini guida messa a disposizione dall’azienda:

- Mount the partition where the /usr directory is located; (necessari i permessi di scrittura)

- Backup all the files before making any changes.

- Remove the file /etc/ld.so.<random>.

- Remove the directory /usr/lib/libc.so.<random>.

- Restore the attributes of the files /usr/share/libc.so.<random>.<arch>.*.so and remove them as well.

- Patch the loader library to use /etc/ld.so.preload again.

- Umount the partition and reboot the system normally.

Questo è un esempio:

Lo svilppo di Umbreon è iniziato nel 2015 e oggi è un rischio per la comunità Linux, pertanto occhi aperti quando installate o scaricate file dal web.

Vi ricordiamo che seguirci è molto semplice: tramite la pagina Facebook ufficiale, tramite il nostro canale notizie Telegram e la nostra pagina Google Plus.

Qui potrete trovare le varie notizie da noi riportate sul blog. È possibile, inoltre, commentare, condividere e creare spunti di discussione inerenti l’argomento.