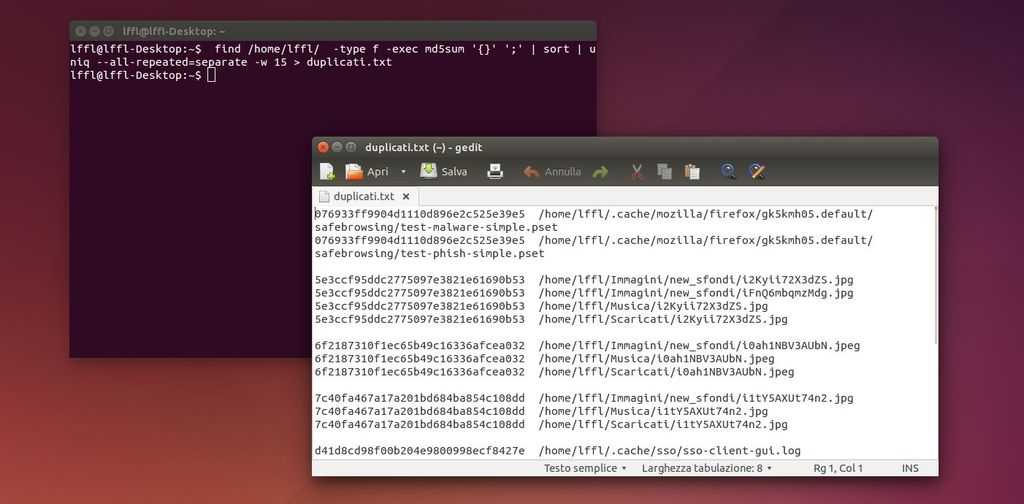

Per far tutto questo vasta digitare da terminale:

find /home/lffl/ -type f -exec md5sum '{}' ';' | sort | uniq --all-repeated=separate -w 15 > duplicati.txt

Dove al posto di /home/lffl/ dovremo indicare il percorso della directory da esaminare, esempio se vogliamo effettuare il controllo della cartella Immagini nel mio caso dovrò inserire /home/lffl/Immagini ecc.

Il comando crea automaticamente un file denominato duplicati nella nostra home nella quale troveremo l’elenco delle immagini duplicate e il loro percorso cosi da poterle rimuovere.

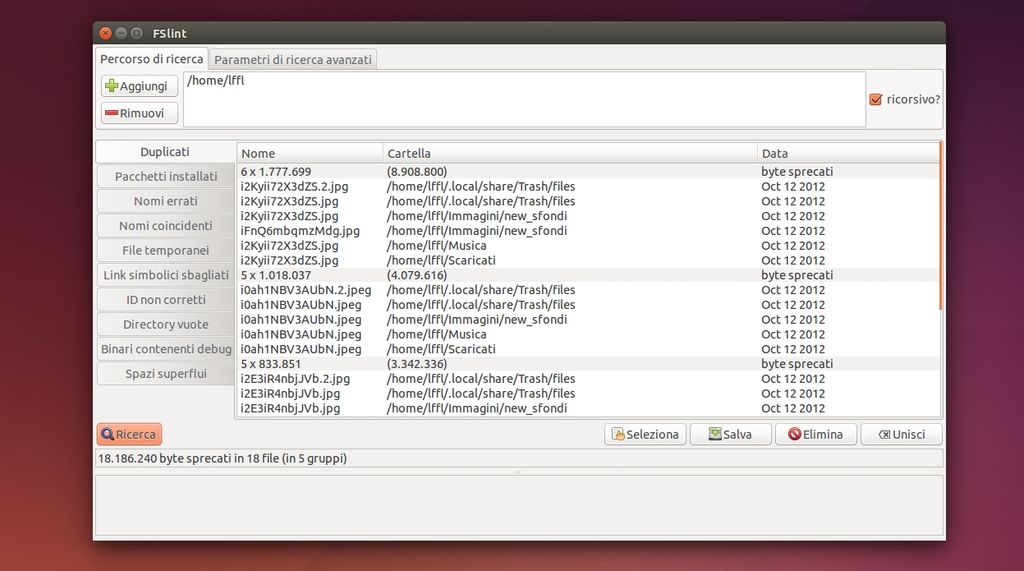

Per chi non ama operare da riga di comando possiamo utilizzare l’applicazione FSlint, utile software incluso nei repository ufficiali delle principali distribuzioni Linux, che ci consente di rimuovere facilmente file duplicati come ad esempio immagini digitali presenti sul nostro pc, hard disk esterni, pendrive ecc oltre a rimuovere file temporanei, pacchetti obsoleti ecc.

Per installare FSlint in Ubuntu, Debian e derivate basta digitare da terminale:

sudo apt-get install fslint

Al termine dell’installazione basta avviare FSLint da menu / dash e su Aggiungi inserire le directory da analizzare, successivamente basta cliccare su Ricerca per avviare la scansione.

Al termine della scansione / ricerca avremo l’elenco dei file duplicati basta selezionarli e cliccare su Elimina per poterli rimuovere.

Per Linux esistono altri comandi da terminale, script e tool per effettuare la ricerca ed eliminazione di file duplicati, questi due a mio avviso sono i più semplici da utilizzare anche da parte di utenti inesperti.